# Ubuntu下配置TensorRT环境

# 先确保安装正确版本的显卡驱动

如果是已经安装的显卡驱动有问题需要卸载可以使用如下方式,

sudo apt-get purge nvidia-*

推荐的Linux下安装显卡驱动的方法,

sudo add-apt-repository ppa:graphics-drivers/ppa ubuntu-drivers devices

sudo apt-get update

sudo ubuntu-drivers devices

# 选择正确版本的驱动进行安装

sudo apt-get install nvidia-driver-*

安装显卡驱动要和系统的内核版本对应好,内核版本和驱动版本不兼容的化会很麻烦。

在这里 (opens new window)可以查寻内核和显卡驱动的兼容关系。

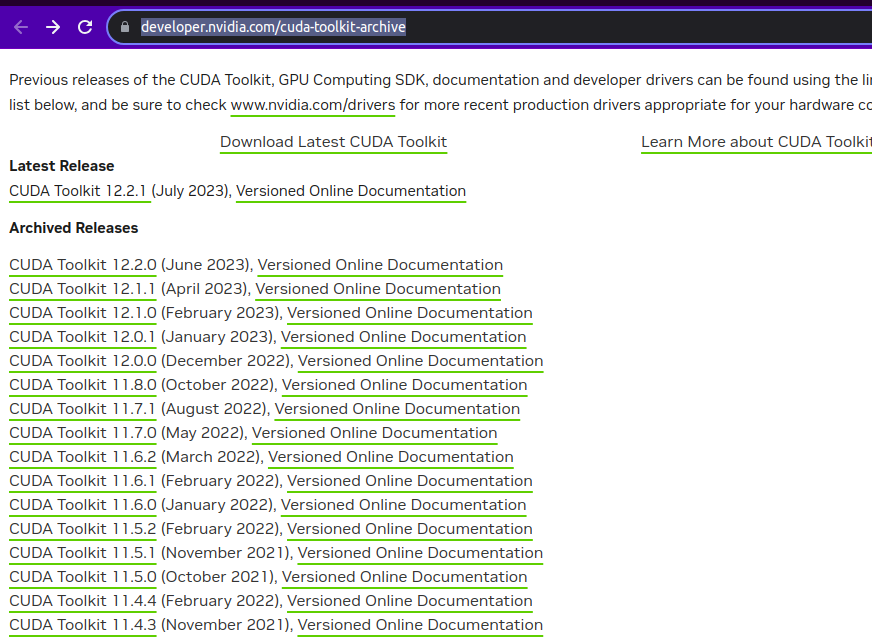

# 安装CUDAToolkit

安装好显卡驱动后,安装CUDAToolKit。

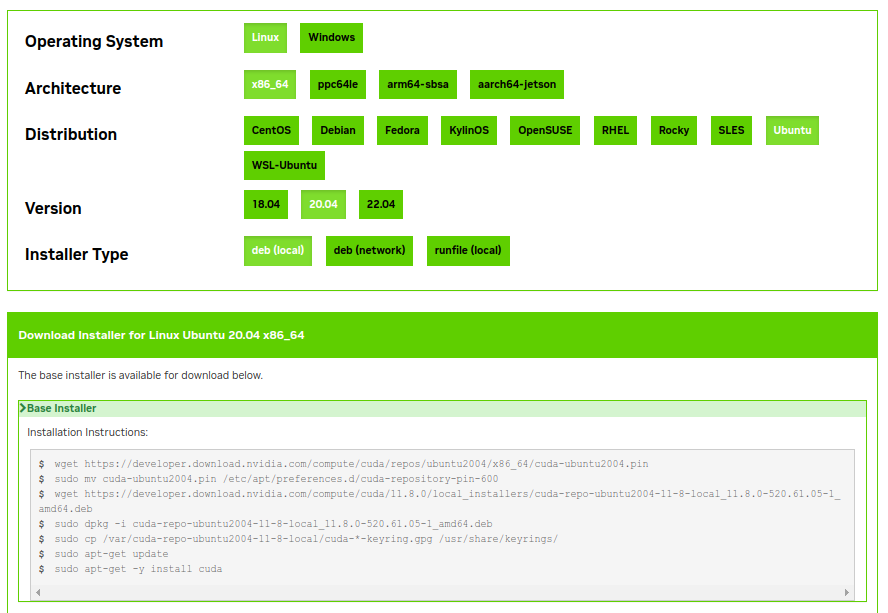

需先查看显卡驱动和CUDAToolkit中的兼容关系。

cudatoolkit and nvidia-driver compatibility (opens new window)

选择好对应的平台和系统后,会给出安装脚本,直接复制粘贴到终端执行就可以。

安装完成后,在/usr/local文件夹下会找到cuda文件夹,里面放有cuda对应的头文件,库文件和可执行文件。

# 安装cuDNN

神经网络中的某些层需要cuDNN的支持。

cuDNN的官方安装指引可以参考Install Instruction (opens new window)。

这里介绍的cuDNN有多种安装方式,这里选择tar包来安装,直接解压后按官方指引复制到cuda安装目录下即可。

sudo cp cudnn-*-archive/include/cudnn*.h /usr/local/cuda/include

sudo cp -P cudnn-*-archive/lib/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

# 安装TensorRT

TensorRT应该是目前在Nvidia显卡上运算速度最快的推理引擎。

其官方安装指引Install TensorRT Doc (opens new window)。

其也有多种安装方式,如deb/zip/tar等。

在Ubuntu下,为了便于升级,和管理多个版本的TensorRT,推荐直接下载tar包解压后放入指定位置,通过设置LD_LIBRARY_PATH来使用。

在这里选择TensorRT (opens new window)下载。

选择GA版本的安装,这里还说明了该版本的TensorRT需要哪个版本的cuDNN和CUDAToolkit。

通过tar包的安装方式指引官方文档可参考这部分tar install (opens new window)

tar包中有Python下的安装包,按上面的指引安装即可。